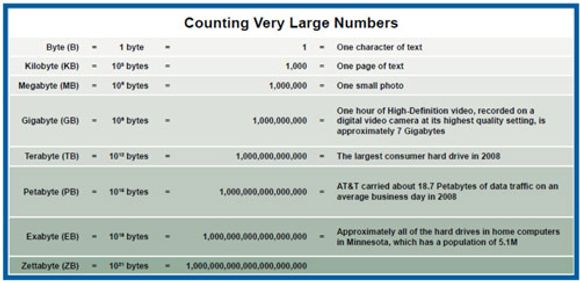

Tre forske ved University of California, San Diego har beregnet at mengden av data som verden omtrent 27 millioner servere behandlet i 2008, var på 9,57 zettabyte. Dette tilsvarer en million million gigabyte eller 1021 byte.

Dette skal være første gang at et slikt estimat har blitt utarbeidet. Beregningen er gjort med utgangspunkt i blant annet informasjon om ytelsesstandarder for serverprosessering, rapporter fra serverindustrien, intervjuer med it-eksperter og salgstall fra serverleverandører.

Forskerne har også beregnet at arbeidsmengden til verdens servere dobles med to års mellomrom. Forskerne har forsøkt å skape et bilde av hvor mye data som vil bli behandlet i 2024 ved å ta utgangspunkt i at man trykker dataene inn i bøker. Dersom hver bok er 4,8 centimeter tykk og rommer 2,5 megabyte med informasjon, ville stabelen med bøker passere stjernen Alpha Centauri som er 4,37 lysår borte.

– Det meste av denne informasjonen er utrolig flyktig – den dannes, brukes og slettes i løpet av noen få sekunder uten at den noen gang blir sett av en person, sier Roger Bohn, prosessor i teknologiadministrasjon ved universitetets School of International Relations and Pacific Studies, i en pressemelding.

– Den eksplosive veksten i lagrede samlingen av tall, bilder og andre data er velkjent, men rene data blir viktigere når de aktivt prosesseres av servere, sier James E. Short, en forskerkollega av Bohn.

Sammen med forskeren Chaitanya K. Baru ved San Diego Supercomputer Center har Short og Bohn lagt fram rapporten «How Much Information?: 2010 Report on Enterprise Server Information» i forbindelse med det årlige møtet til Storage Networking World i Santa Clara, California, i forrige uke.

– Etter hvert som servernes kapasitet til å prosessere det digitale universets voksende informasjonsgrunnlag, også fortsetter å øke, skaper utviklingen i seg selv hittil ukjente utfordringer og muligheter for bedriftenes informasjonsledere, sier Short.

– Vi kunne selvfølgelig ikke direkte måle lastfordelingen til millioner av servere verden over, men vi mottok viktig rettledning fra eksperter, bransjedata og vår egen vurdering, legger han til.

Forskerne har også kommet fram til at 65 prosent av verden informasjon i 2008 ble prosessert på små servere. Ifølge forskerne vil dette si servere som koster under 25 000 dollar. Servere som koster over 500 000 dollar prosesserte derimot bare 5 prosent av informasjonen, mens mellomklasseserverne stod for 30 prosent.

En svakhet i rapporten, som forskerne selv trekker fram, er at den ikke fullt ut inkluderer servere som ikke er levert av de store serverprodusentee. For eksempel benytter Google servere som selskapet selv har utviklet. Men også Microsoft og Yahoo nevnes i denne sammenheng.