Teknologidirektør Hubert Yoshida i lagringsleverandøren Hitachi Data Systems, var i Norge i forrige uke i forbindelse med et arrangement for kunder og partnere, og tok seg tid til en times intervju med digi.no.

Yoshida er opptatt av en opplagt problemstilling. Det er trange tider, og IT-budsjettene strammes til. På den andre siden legger økonomiske utfordringer ingen demper på den eksponentielle veksten i den digitale informasjonsmengden som bedrifter må ta vare på, og helst gjøre seg enda bedre nytte av. Dette forsterker virkningen av negative tendenser som man ikke gjorde noe med i gode tider.

– Svært mye innen IT bygger på ting som er veldig gamle. Det er et akutt behov for modernisering. Overalt er det infrastrukturer som ikke ble konstruert med tanke på dagens behov. Analyseselskapet Gartner peker på at dette kan ikke vedvare. Gjør man ikke noe med det, vil vi oppleve at systemer plutselig stanser helt.

Yoshida viser blant annet til hva som skjer når du bestiller en flybillett over Internett. Alt ser moderne ut. Men alt avhenger av flere tiår gamle stormaskinsystemer som ble utviklet under helt andre forhold og med helt andre forutsetninger.

– Er det ikke slike utfordringer som skulle løses ved å kapsle inn gamle tjenester og gjøre dem tilgjengelig gjennom nye tjenesteorienterte arkitekturer?, spør teknologijournalisten.

– Innkapsling endrer ikke på det grunnleggende samspillet. Her må det endringer til, svarer industrilederen.

Yoshida trekker fram hva som skjer innen hans eget felt, lagring, når en banebrytende teknologi kommer på banen.

– Vi tilbyr i dag flashdisker [SSD for «solid state disc»] for bestemte behov. Vi får dette til å virke, og gi klare fordeler, selv om vi fortsatt holder oss til kodebaner som ble utviklet for roterende disker. Disse kodebanene forutsetter at det kan ta millisekunder å hente fram data. Denne forutsetningen holder ikke lenger. I det lange løp kan vi ikke leve en løsning som bare kapsler inn dette problemet. Før eller siden vil vi møte veggen, og det vil være umulig å flytte gamle applikasjoner og data til en ny plattform. Jo lenger vi venter desto større blir sammenbruddet og kostnadene som må til for å løse det.

Jeg får en assosiasjon til et ordtak jeg lærte som barn: «A stitch in time saves nine.»

Yoshida fortsetter:

– Lagringsressurser disponeres jevnt over feil i bedrifter i dag. Det typiske er at bare 25 prosent av den fysiske kapasiteten utnyttes effektivt. Svært mye av dataene som lagres brukes ikke til noen ting. Stadig flere ressurser går til drift og vedlikehold i stedet for til nye løsninger. Foreldet infrastruktur gjør det vanskelig å flytte kritiske data fysisk uten å gjøre dem midlertidig tilgjengelig. Den økonomiske krisen betyr ikke bare kutt i IT-budsjettene. Den skjerper behovet for at IT bidrar til den fleksibiliteten bedriften trenger for å realisere nye ideer som kan bære virksomheten gjennom krisen.

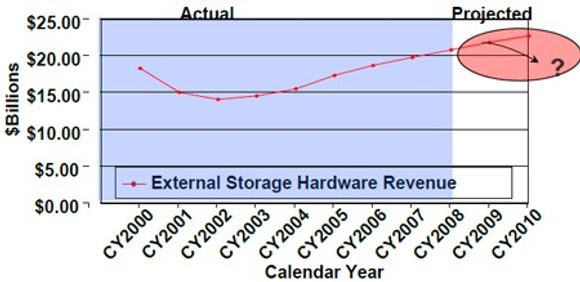

Yoshida trekker fram denne grafen, som viser IDCs anslag over den globale omsetningen av lagringssystemer i årene 2000 til 2008.

– Her ser du at det var først i 2007 at lagringsmarkedet vokste forbi nivået fra 2000. IDC forutså opprinnelig vekst i både 2009 og 2010. Antakelig må de revidere denne oppfatningen. Nedgangen vil merkes allerede i år, og den vil fortsette neste år.

For ni år siden fikk krisen bedriftene til å satse på maskinvarekonsolidering for å redusere utgiftene mens man økte lagringskapasiteten.

– Situasjonen i dag er fortsatt slik at etterspørselen etter lagringsplass fortsetter å akselerere. Men i dag kan man ikke bare satse på å redusere de løpende investeringene i lagring. Man må også redusere driftsutgiftene. Slik vi ser det, kan man ikke nøye seg med å kreve å få igjen for det man har investert. Man må først og fremst sørge for å få mer ut av det man har.

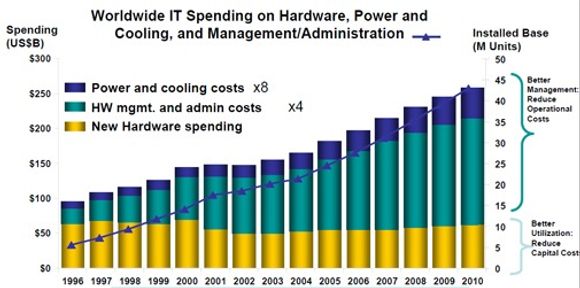

Yoshida viser denne plansjen med data fra IDC, for å anskueliggjøre hvordan investering i ny maskinvare utgjør en stadig mindre del av de totale utgiftene til IT-systemer.

Kapitalutgiftene har med andre ord holdt seg på omtrent det samme nivået de siste tolv årene, mens driftsutgiftene er mangedoblet.

– Derfor kan vi ikke lenger bare snakke om «return on investment». Vi må nå snakke om «return on assets», sier Yoshida.

Det betyr ikke å blåse i tiltak for å utnytte den fysiske lagringskapasiteten mer effektivt. Yoshidas poeng er at hvis man nærmer seg problemet fra et mer helhetlig perspektiv, med utgangspunkt i drift, vil man også komme fra til mer virkningsfulle løsninger.

– Lagringssystemene fylles av gamle data, av kopier, og av tomrom. Av hensyn til ytelse, sikkerhet og en rekke andre faktorer, utføres mange oppgaver – analyse. Sikkerhetskopiering og så videre – ikke på originale data, men på kopier. Systemer for analyse og beslutningsstøtte tar nye øyeblikksbilder av aktive data flere ganger i døgnet, for at systemene skal kunne gi aktuelle svar. Vi har erfart at i noen organisasjoner opererer man med et tjuetalls kopier av sine data.

Andre årsaker til overbelastning av lagringssystemer, ifølge Yoshida, er at man bestandig tildeler applikasjoner langt mer lagring enn de faktisk utnytter, at brukere hoper opp data til eget bruk fordi de ikke vil eksponere seg for andre, og at man investerer i fysisk lagringskapasitet med utgangspunkt i det beregnede behovet om tre år. Etablerer man så en sikkerhet basert på RAID 1, dobles alt dette. Resultatet er at det totale omfanget er svært mange ganger større enn den datamengde man faktisk trenger.

– Det innebærer at det fortsatt er mye å hente på å effektivisere selve den fysiske lagringen. Men kostnadsutviklingen viser at ineffektiv drift er langt mer belastende for bedriftens økonomi enn overinvesteringer i fysisk lagring. Fordeler man lagringskostnader på kapital og drift, kommer man til at driften koster fra det dobbelte til det firedobbelte av det man betaler for selve lagringssystemene.

Et eksempel Yoshida trekker fram, er hva det i snitt koster å flytte én terabyte data fra ett system til et annet: 10 000 dollar.

Det allmenne svaret på dette, ifølge Yoshida, kan oppsummeres i fire punkter:

- Man må fortsette å konsolidere lagringssystemet.

- Man må bruke virtuell tilrettelegging («thin provisioning») for å utnytte de fysiske ressursene bedre.

- Man må ty til metoder som komprimering og deduplisering for å redusere den samlede datamengden.

- Man må bygge opp et enhetlig og felles arkiv hvor man kan flytte alle inaktive data og slette alle kopier.

– Alt dette har med drift å gjøre. Konsolidering krever for eksempel evnen til å flytte data uten å gjøre tjenestene utilgjengelige for brukerne. Virtuell tilrettelegging betyr at tjenester kan kjøres som om de har tilgang til ubegrensede mengder data: I virkeligheten har de knapt mer enn de faktisk utnytter. Poenget er at man kan straks merke når det er behov for mer plass, og man kan straks tildele det som trengs.

– Det blir som når flyselskap overbooker for å sikre bedre utnyttelse?

– I prinsippet, ja. Men i motsetning til flyselskapene, gjør virtuell tilrettelegging det mulig straks å sette inn flere fysiske seter, bare man har noen på lager.

Virtualisering av fysiske ressurser er forutsetningen for å realisere alt dette. Alle lagringsressurser i en organisasjon må kunne utnyttes som om de var ett felles system, uansett om de er knyttet til stormaskiner, eksterne disker (NAS, for «network attached storage»), interne disker, virtuelle servere eller andre systemer, som CAS («content adressable storage»).

For å realisere de fire punktene, har Hitachi bygget en løsning de kaller «Universal Storage Platform». Alle lagringsressurser styres gjennom en egen enhet – «Storage Control Unit» – som står for alle lagringstjenester i nettverket. Denne enhetens oppgave er altså å virtualisere all lagring og levere det videre som tjenester. Applikasjonene i nettverket får tilgang til det de trenger, når de trenger det. Yoshida understreker at denne virtuelle tilretteleggingen er dynamisk. En applikasjon kan få nye titalls eller hundretalls gigabytes på noen minutter.

En sentral komponent i denne plattformen er et felles arkiv.

– I dag er arkiver bygget opp som uavhengige siloer. E-post arkiveres i én silo, pasientjournaler i en annen, røntgenbilder i en tredje, for å ta et eksempel fra helsesektoren. Vi har bygget opp en plattform for innholdsarkivering, «Content Archive Platform», som gjør at alle arkiv kan betraktes under ett. Den kan skaleres til 20 petabytes og 32 millioner objekter, og tilbyr blant annet felles søk gjennom hele arkivet. For å finne all data om en pasient, behøver man ikke søke gjennom mange arkiv hver for seg. Ett søk gir alt om e-post, journaler, røntgen og så videre.

De lagringsspesifikke tjenestene som denne driftsplattformen samler, er blant annet nivåinnstilt lagring («tiered storage», der fysisk medium velges ut fra hva som er mest hensiktsmessig, gitt hvordan dataene brukes), tilrettelegging, virtuell tape, replikering, komprimering, deduplisering, kryptering, og så videre.

– Denne plattformen for lagring gjør det mulig å utnytte de trange tidene til å modernisere IT. Man kan redusere behovet for investeringer, redusere driftskostnadene, og samtidig få et system som straks kan skaleres opp når tidene blir bedre og nye behov melder seg. IT kan med andre ord bli helten for både gode og dårlige tider.

Den som tenker seg å høste fordeler fra en slik plattform, må overbevises om at det er mulig å lage en avbruddsfri overgan, og at løftene om reduserte kostnader også gjelder i deres tilfelle. Hitachi har utarbeidet en rekke hjelpemidler, i form av både tjenester og verktøy.

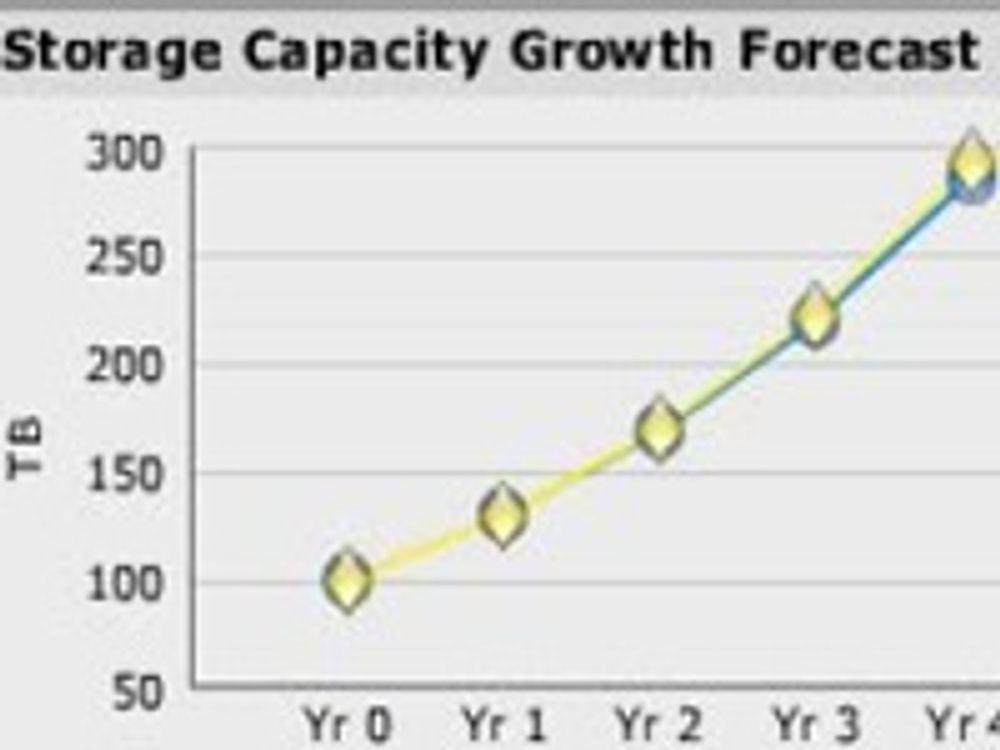

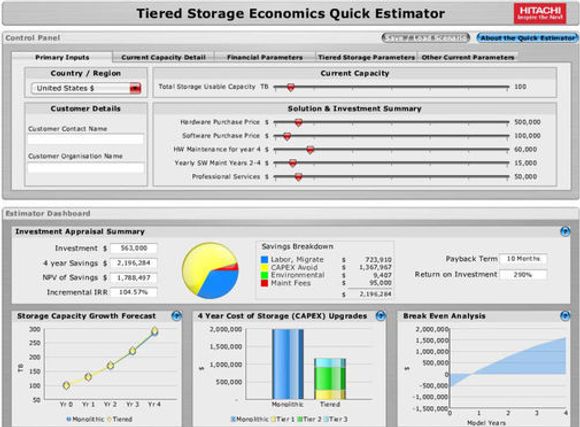

– Et par timers samtale og gjennomgang er grunnlaget for å bruke dette verktøyet for å anslå både veksten i lagringsbehov i årene framover, og hvordan vårt system kan bidra til å redusere kostnadene, sier Yoshida, og viser dette skjermbildet:

Han mener det typisk kan være mulig å oppnå en kostnadsreduksjon på 24 prosent over en tre års periode, samtidig som man oppnår smidigere, mer effektiv og mer moderne lagring.

– Miljøet behøver ikke være så veldig stort, det kommer an på hvilke behov man har og hvordan man forholder seg til drift og data. Stenger man butikken hver natt, kan man selvfølgelig nøye seg med gamle systemer der det kan legges opp mye nedetid. Er effektiv lagring spesielt kritisk, kan vår tilnærming være hensiktsmessig selv med bare 10 til 20 terabytes samlet lagring. Vi kan starte med en pakke til rundt 100 000 dollar, der det for eksempel ikke er nødvendig med forhøyet gulv.

Les også:

- [10.02.2010] Lar pasienten lese journal på nett

- [07.09.2009] Redusert marked for ekstern lagring

- [09.07.2009] Rimelig deduplisering for bedrifter

- [25.06.2009] IBM-forsker påviser perfekt infovern

- [10.06.2009] Nå krymper også lagringsmarkedet

- [19.05.2009] Digitale arkiv krever egen makulering

- [13.03.2009] Gjør investeringer til sparetiltak

- [09.03.2009] Utfordrerne øker mest innen lagring

- [26.02.2009] Virtualisert lagring med garanti

- [20.02.2009] Citrix gir bort Xenserver

- [20.02.2009] Superdisker kan svikte tunge brukere

- [10.02.2009] Banebrytende fra Sandisk

- [13.01.2009] Doblet lagringsplass i ny flashdisk

- [06.01.2009] Rekordtett datalagring på nye harddisker

- [29.12.2008] Benytt julefreden til å rydde på serveren

- [02.12.2008] Intel og Hitachi sammen om flashdisk for servere

- [28.11.2008] Ny komponent kan skape lagringsrevolusion

- [10.11.2008] Sun tilbyr friprog-lagring