- Det begynner å dukke opp flere saker om med hvilken rett ulike typer søkemotorer indekserer, henter, lagrer og presenterer pekere fra andre nettsider, typisk nettaviser, konstaterer Nicolai Lorentzen i selskapet Wide Computing, og sikter til Newsbooster-saken i Danmark og en tilsvarende sak i Tyskland.

Han mener flere nettaviser bør vurdere å forby søkemotorer som ukritisk og fortløpende søker gjennom avisens innhold, og i stedet selv velge ut hvilke lenker søkemotoren skal få tilgang til.

- Både av opphavsrettsgrunner og et rent ytelsesmessig kapasitetshensyn bør den enkelte nettavis med en lokal crawler selv indeksere sitt innhold og så overføre en ferdig indeks til søkemotorene. Da vil indeksen alltid være oppdatert, og siden du kun sender over det innholdet som har endret seg siden forrige indeksering, vil dette også ha en positiv effekt på kapasiteten til søkemotorene, sier Lorentzen til digi.no.

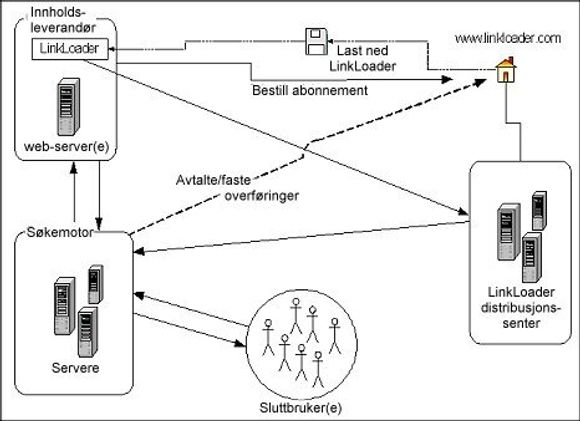

Hans selskap, Wide Computing, har derfor utviklet en løsning kalt LinkLoader (skisse under) som gjør det mulig å gjennomføre kontrollert overføring av pekere og innhold til søkemotorer.

Som figuren viser, består systemet består av en klientprogramvare som lastes ned og installeres på eller i nærheten av innholdsleverandørens webserver. Klienten konfigureres i forhold til hvor ofte overføringen ønskes, hvilken deler av nettstedet som ønskes overvåket og til hvilken søkemotor linkene skal sendes.

LinkLoader (se demo her) overvåker nettstedet innenfra og overfører informasjon om nye, endrede og slettede URL-er. Dette gjør at søkemotorene bare trenger å indeksere de få endringene som er gjort siden siste, og ikke hele nettstedet.

- Dette letter på kapasitetspresset til søkemotorene, samtidig som innholdsleverandøren slipper den belastingen nettstedet får når en søkemotors crawler "voldtar" nettstedet, sier Lorentzen.

Ifølge Wide Computing viser statistikk at under 0,5 prosent av sidene på Internett endrer seg hver dag. Av det trekker de den slutning at over 99,5 prosent av trafikken mellom innholdsleverandørene og søkemotorene kunne vært unngått dersom man i stedet hadde benyttet løsninger a la LinkLoader. Når man vet at anslagsvis 30-40 prosent av all trafikk på nettet skjer via søkemotorer, er det med andre ord et viktig arbeid å gjøre søkemotorene enda mer oppdatert, uten at det spiser det som finnes av kapasitet.

LinkLoader-klienten finnes i flere varianter, alt fra en gratis nedlastbar versjon til løsninger som gjør det mulig å ta seg betalt for linkene, med tilhørende betalings og faktureringsløsninger - muligens en ideell løsning for alle nettaviser som blir hjemsøkt av spisse monitorerings- og søketjenester, som lever av og videreformidle lett fangede nyheter til sine betalende sluttbrukere (f.eks. Observer, Intermedium, Cyberwatcher, Infopaq). Her settes løsningen opp som en tjeneste som gjør det mulig å kreve betaling før overføringen av linker/innhold finner sted.

Om Wide Computings LinkLoader blir en suksess avhenger av hvorvidt de enkelte innholdsleverandørene installerer løsningen og om søkemotorene gjør det samme. De sistnevnte er kanskje enklest å overtale ettersom en omfattende spredning av løsningen på årsbasis vil kunne bety sparte millionutgifter bare på søke- og indekseringssiden.