Man kan lære mye av å se på hvordan andre utfører oppgaver. Nå har forskere ved University of Maryland (UMD) lykkes i å gi roboter nye kunnskaper på samme måte.

Ifølge universitetet er det forholdsvis greit for roboter å lære å gjenkjenne objekter og mønstre. Men å tolke og kunne handle på bakgrunn av visuelle inntrykk, er mye vanskeligere. Forskere ved det amerikanske universitet har nå utviklet et system som gjør det mulig for roboter å prosessere visuelle data hentet fra en serie med «how to»-videoer om matlaging som finnes på YouTube.

Basert på det som vises i videoene, kan robotene gjenkjenne, gripe fatt i og manipulere det riktige kjøkkenredskapet eller -objektet og utføre oppgaven som demonstreres, med stor grad av nøyaktighet. Det hele gjøres uten menneskelig inngripen eller programmering.

Matlaging

– Vi valgte matlagingsvideoer fordi alle har gjort det og forstår det, sier Yiannis Aloimonos, som er professor i informatikk ved UMD, i en pressemelding.

– Men matlaging er komplekst når det gjelder manipulasjon, trinnene som er involvert og verktøyene du bruker. Dersom du ønsker å dele en agurk, for eksempel, må du gripe kniven, plassere den på riktig sted, utføre kuttingen og observere resultatene for å forsikre deg om at du gjorde det skikkelig, sier Aloimonos.

Det er Mathematics of Sensing, Exploitation and Execution-programmet (MSEE) til DARPA som har finansiert forskningsprosjektet. Dette programmet har som mål å utforske og utvikle metoder for læring, planlegging og utføring av komplekse oppgaver – metoder som kan brukes av skalerbare, autonome systemer som kan forstå scenerier og hendelser.

– MSEE-programmet fokuserte i begynnelsen på sansing, som involverer inntrykk og forståelse av hva som skjer i en visuell scene, i stedet for bare å gjenkjenne og identifisere objekter, sier Reza Ghanadan, en programsjef ved DARPAs Defense Sciences Offices, i en pressemelding.

Han forteller at man nå har tatt skrittet videre, til utførelse, hvor roboten prosesserer visuelle tegn via en spesiell «manipulation action-grammar»-modul og oversetter dette til handlinger.

Kopierer målene

– Andre har forsøkt å kopiere bevegelser. I stedet forsøker vi å kopiere målene. Det er dette som er gjennombruddet, forklarer Aloimonos, som legger til at denne tilnærmingen gjør det mulig for robotene å avgjøre selv hvordan de best kan kombinere ulike handlinger, i stedet for å reprodusere en forhåndsbestemt serie med handlinger.

Ifølge DARPA vil forskningen også bidra til robotenes evne til å samle kunnskap og å dele dette med andre. Typisk for dagens sensorsystemer er at de til enhver tid opplever verden på ny, uten å ha evne til å anvende forkunnskaper.

– Dette systemet lar roboter kontinuerlig bygge på tidligere læring, om for eksempel typer av objekter og hvilket grep som er knyttet til dem, noe som kan ha stor betydning for undervisning og trening. I stedet for den lang og kostbare prosessen ved å programmere kode for å undervise roboter i å gjøre oppgaver, åpner denne forskning potensialet for at roboter kan lære mye raskere til mye lavere kostnader, samt, samt å dele denne kunnskapen med andre roboter, innenfor det de er autorisert til å gjøre. Denne læringsbaserte tilnærmingen er et betydelig skritt mot utvikling av teknologier som kan være nyttig innen områder som militær reparasjon og logistikk, sier Ghanadan.

Samhandling

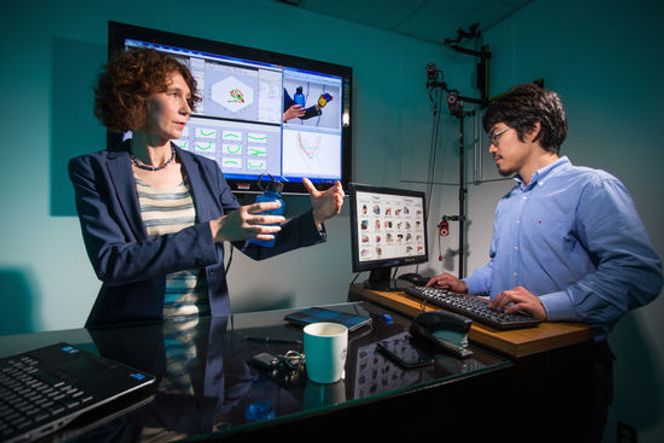

Cornelia Fermuller, en forsker med University of Maryland Institute for Advanced Computer Studies (UMIACS), forteller at man også forsøker å skape en teknologi som på sikt kan gjøre det mulig for roboter å samhandle med mennesker.

– Da er det nødt til å forstå hva mennesker gjør. Til dette trenger vi verktøy som gjør at robotene kan registrere et menneskes handlinger og følge disse i sanntid. Vi er interessert i å forstå alle disse disse komponentene. Hvordan blir en handling utført av mennesker? Hvordan blir den oppfattet av mennesker? Hva er de kognitive prosessene bak dette?, sier hun.

Selve forskningsartikkelen er tilgjengelig her.