Et cyberangrep kan arte seg på mange måter og ha mange ulike motiv. Krypteringsvirus eller løsepengevirus er en metode som har økt dramatisk i omfang, spesielt det siste året. Tidligere var det det gjerne privatpersoner og en enkelt PC som ble rammet. Nå går selskaper og hele konsern ned for telling. Fra utsiden har vi selv sett hvordan selskaper som Maersk, Hydro og andre har blitt rammet. Lite visste vi om hva vi selv hadde i vente.

Noen hendelser i livet husker man for alltid. Det som skjedde 30. oktober 2019 kommer jeg aldri til å glemme. Jeg ble varslet om IT-problemer på vei til jobb, noe som skjer fra tid til annen. Men denne morgenen var det annerledes. I gangen på kontoret står teknisk leder og ber alle om som kommer inn om å ikke koble PC-ene til nett. Alle servere er kryptert, ingenting virker.

Hva skjer med en organisasjon som blir rammet, og hvilke faser går man igjennom? Dette er historien om et cyberangrep sett fra innsiden.

Sjokket

Vi opplever alle IT-problemer i hverdagen. Driftsforstyrrelsene er gjerne korte, men allikevel blir vi stresset og irritert. Vi er helt avhengig av å ha tilgang til data og at systemene fungerer.

Å få vite at alle servere og data er kryptert er en sjokkartet opplevelse. Det tar tid å fordøye konsekvensene og forstå rekkevidden av at noen har «kidnappet» dataene dine, selve fundamentet for normal drift.

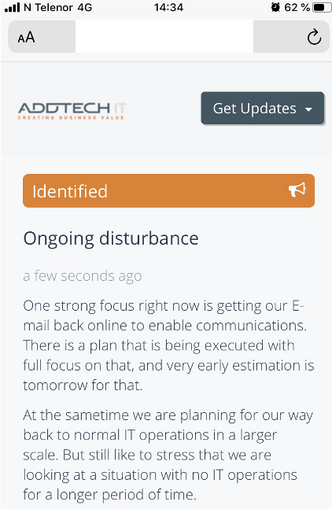

I løpet av morgentimene 30.oktober fikk vi flere meldinger fra sentral IT. Det mest dramatiske var ikke ordene som ble brukt, men konsekvensene av det som stod der.

Smak på den siste setningen i meldingen i skjermbildet til høyre. Hva ville det ha betydd for deg og din organisasjon?

Tidslinje og fremdrift

For hva betyr egentlig «..we are looking at a situation with no IT operations for a longer period of time»? To dager, en uke, eller mer? Svaret var avgjørende for hva vi skulle gjøre og tenke videre. Ingen kunne fortelle oss det.

Vi kommuniserte tidlig internt at vi måtte belage oss på minst to uker uten data og systemer

Vi måtte selv bedømme situasjonen, og innså raskt at dette kom til å ta tid. Vi kommuniserte tidlig internt at vi måtte belage oss på minst to uker uten data og systemer. Bare det å si det høyt løste mye for oss i denne første fasen. Omfanget sank inn. Beslutningene vi måtte ta ble enklere. Det ble selvsagt at vi måtte kjøpe inn nye PCer, sette opp et nytt midlertidig nettverk og informere kunder.

Opprettelsen av en tidslinje gav oss energi og fremdrift i en akutt krise. Det ble klart at vi skulle løpe maraton og ikke en sprint.

Kommunikasjon og åpenhet

Konsernet vi er en del av var blitt utsatt for en kriminell handling. Dette kommuniserte vi internt. Vi skulle ikke føle skyld eller skam, og energien måtte rettes fremover på det vi kunne gjøre noe med.

Hyppige allmøter med åpen og direkte kommunikasjon rundt situasjonen ble et effektivt virkemiddel for å samle troppene og unngå kaos.

Eksternt valgte konsernet å kommunisere med åpenhet. Det medførte forståelse fra kunder og leverandører, og de ansatte trengte ikke å skjule noe.

Dataene er borte – lenge leve dataene!

Office 365 og Internett ble våre eneste følgesvenner i en lang periode. Alt av administrative systemer og data var utilgjengelig.

Alle eksisterende PCer som ikke var kryptert ble sett på som «skitne», og kunne ikke kobles til nett. Informasjonen som lå der kunne ikke deles.

Fakta om angrepet

Onsdag 30.oktober 2019 ble Addtech AB utsatt for et omfattende cyberangrep. Angrepet var i form av «ransomware» og omfattet 80 av konsernets 130 selskaper, dette tilsvarer ca. halvparten av konsernets omsetning på 10 milliarder SEK.

Addtech AB har informert markedet om at cyberangrepet har kostet konsernet 150millioner SEK. Ingen løsepenger har blitt betalt.

Men hadde vi allikevel data og informasjon som kunne hjelpe oss videre?

Fra et pågående prosjekt på lageret hadde vi en utskrift over de fleste lagerførte produkter med tilhørende lagerlokasjoner. Tellelister som var lagret hos revisor kompletterte bildet.

Vi fikk tak i prislister for de viktigste leverandørene. Fra webshop-løsningen i skyen, kunne vi få ut kontaktinformasjon til mange av kundene våre. Basert på tilfeldigheter og flaks fikk vi tak i vitale data som til sammen var helt avgjørende for videre drift.

Et midlertidig lokalt IT-system ble etablert og der kunne de få dataene vi hadde deles og nye data kunne opprettes og lagres.

Manuell drift

Helt ærlig – vi hadde ingen plan for å operere uten våre systemer. En slik problemstilling hadde vi faktisk aldri snakket om eller diskutert. Det var utenkelig.

Med en tidslinje på minst to uker, ble det også klart at vi måtte etablere manuelle rutiner for alle operasjoner som tidligere var automatisert, eller hvor systemene i stor grad støttet oss i arbeidet. I praksis skulle vi gjøre det samme som før, bare uten systemer.

Alt tok lengre tid og var mer komplisert å utføre. Prioritering av oppgaver ble nødvendig. Å motta bestilling fra kunde og sørge for utsendelse av varer ble prioritert fremfor å sende ordrebekreftelse med leveringstid. Servicenivået sank, det følte hele organisasjonen på.

Etter hvert kom vi over i en ny «normalsituasjon» hvor rutiner var etablert og dagene gikk i hverandre. Sånn sett spilte det liten rolle om vi skulle holde ut i to uker eller tre uker. Bortsett fra at vi brukte langt mer energi enn normalt. Vi var satt minst 20-30 år tilbake i tid – det kostet.

Og det var virkelig en maraton vi skulle gjennomføre. Vi var i manuell drift i fem lange uker.

Vi får systemene tilbake

Når vi igjen får kontakt med systemene og serverne er det ingenting som fungerer. Nye sikkerhetsmekanismer er på plass og flere endringer er utført. Resultatet er at systemer og integrasjoner ikke kan tas i bruk umiddelbart. Interne ressurser og eksterne konsulenter bruker godt over en uke på å få de mest kritiske systemene klare for bruk.

Det ligger mye «tuning» bak velfungerende IT-systemer og integrasjoner

Det ligger mye «tuning» bak velfungerende IT-systemer og integrasjoner. Det er mange detaljer og innstillinger utført over flere år som utgjør systemene slik vi kjente dem. En del av denne løypen måtte nå gås opp på nytt. Det ble en tidkrevende og frustrerende fase som varte i flere måneder før alt var tilbake til status quo.

Så hvorfor tok det så lang tid?

Vi var ikke alene, våre søsterselskaper var også på vei tilbake. Alle skulle ha hjelp. IT-support gikk i overflow. De enkleste ting tok lang tid. Samtidig skulle sikkerheten være i høysetet, ingenting skulle utsette konsernet for ytterligere risiko.

En siste kraftanstrengelse

Mens vi var i manuell drift, produserte vi data hver dag – mye data. En gryende uro gjorde seg etter hvert gjeldene ettersom tiden gikk. En stor del av disse dataene og transaksjonene måtte legges inn i systemene våre når de kom tilbake, samtidig som det kom til å være full operativ drift. Det ble klart at vi skulle legge inn en sprint på slutten av en lang maraton.

Redningen for oss ble den gode strukturen og rutinene i den manuelle driften. Dette var avgjørende for å kunne konvertere data og transaksjoner tilbake inn i systemene. Arbeidet gikk også i etapper, først alle logistikktransaksjoner, og helt til slutt en enorm jobb med å komme ajour regnskapsmessig.

Refleksjon

Å bli utsatt for et cyberangrep har vært vårt selskaps største krise

Å bli utsatt for et cyberangrep har vært vårt selskaps største krise. I mange år har vi jobbet målrettet for å automatisere interne arbeidsoppgaver og bygge opp digitale løsninger rundt våre arbeidsprosesser. Følelsen av å miste alt dette kan ikke beskrives. Vi kom velberget ut på andre siden, men det er ingen selvfølge at DU gjør det. Tro meg.

Hva har vi lært?

- Alle kan bli rammet av cyberangrep. Spøken om at det finnes kun to typer selskaper, de som er hacket og de som ikke vet at de er hacket, er kanskje ikke så langt fra sannheten. Ta cybersikkerhet på alvor.

- Åpenhet og god kommunikasjon gir deg goodwill både internt og eksternt og fører til økt kunnskap og forståelse i samfunnet.

- I en akutt krise er det viktig å etablere en tidslinje og fakta slik du tolker situasjonen. Ta aksjoner og avgjørelser på bakgrunn av dette. Da får du fremdrift og en retning. Feil kan du alltid korrigere underveis. Uten fremdrift har du ingenting.

- Identifiser hvilke data du trenger som et minimum for å operere i en krisesituasjon uten nettverk, systemer og servere. Inkluder også data som ligger i sky-løsninger. Aktuelle data kan være lageroversikt, kundeliste, prislister osv. Bestem hvor disse dataene skal lagres og hvor ofte de skal oppdateres. Da har du etablert en baseline for en situasjon der alt annet svikter.

- Hva er de mest kritiske arbeidsoppgavene og hvordan kan disse utføres uten bruk av dine vanlige systemer? Beskriv dette i en prosedyre og oppbevar sammen med de andre dataene du har for en slik situasjon.

- Sky-løsninger kan brukes for å redusere risiko for at flere systemer blir utilgjengelig samtidig.

En stor takk til alle kollegaer, IT-support, konsernet, kunder og leverandører.

Industrikonsern med over 20 norske datterselskap ble slått ut av kryptovirus