Torsdag 7. september annonserte regjeringen at de vil bevilge en milliard kroner over fem år på kunstig intelligens (KI). Språkmodeller har tatt verden med storm og har mye av æren for dette fokuset. I disse modellene ligger det et stort potensial for innovasjon og verdiskapning i privat og offentlig sektor. I mange tilfeller vil det kreve at vi har gode, oppdaterte språkmodeller som behersker norsk, og at de er tilgjengelige for alle som vil bruke dem.

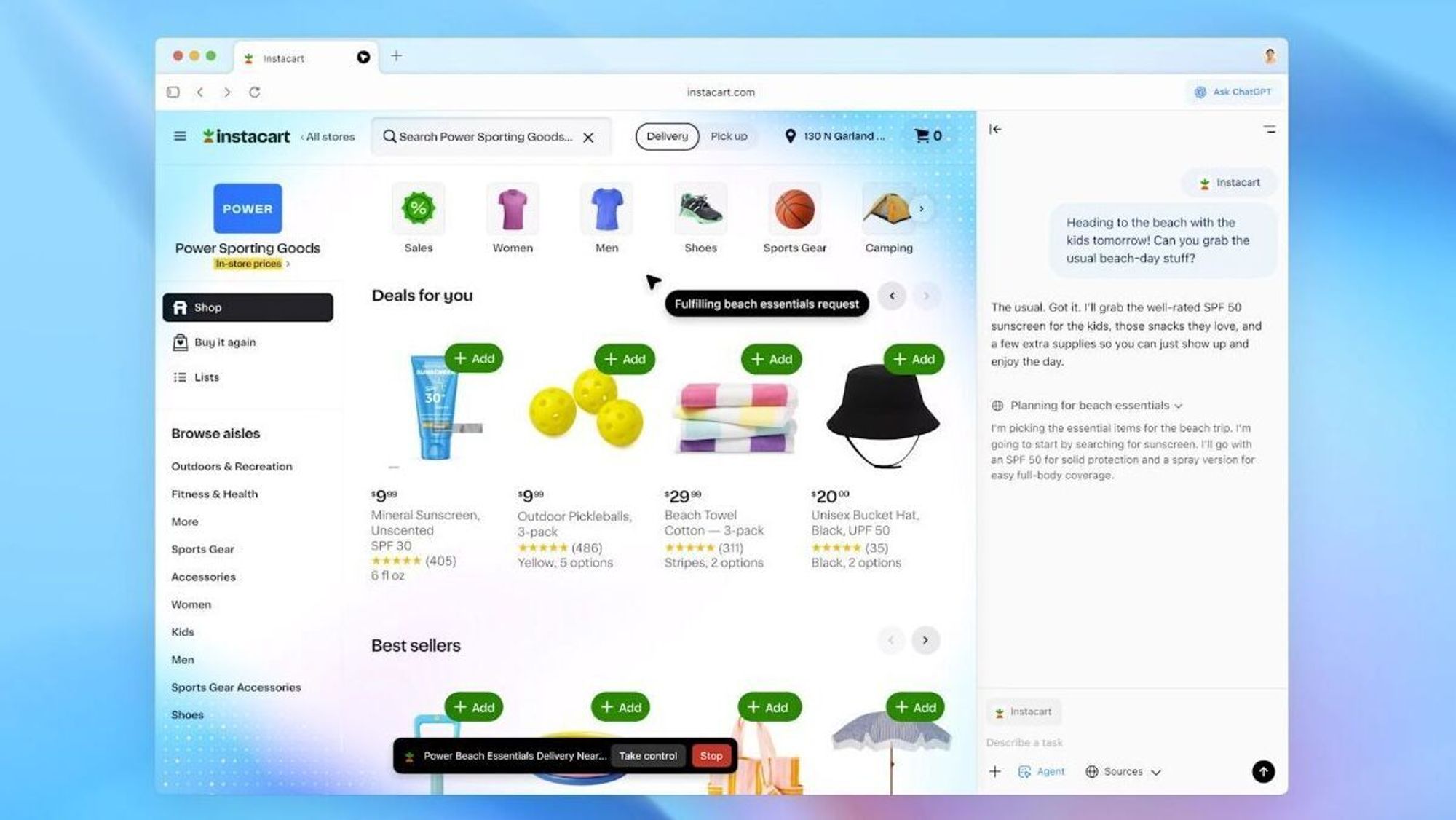

Det finnes både proprietære og åpne språkmodeller, og store selskaper kappes om å ha den beste proprietære språkmodellen: OpenAI har GPT-4, Google har Bard og Anthropic har Claude. Felles for disse modellene er at de er svært enkle å ta i bruk. Gjennom proprietære apper og API-er, som ChatGPT, kan brukere enkelt generere tekst. Brukervennlighet har bidratt mye til modellenes suksess, men betyr også et økt avhengighetsforhold til disse appene. Avhengighet til API-er er en solid forretningsmodell som det er vanskelig for bedriftene å komme seg ut av. I tillegg baserer en slik forretningsmodell seg på at selve modellen (modellvektene) forblir en godt bevart hemmelighet.

Glem språkmodeller: Verdensmodeller kan bli den nye KI-frontlinjen

Samtidig ser vi en økende trend i etablering og bruk av åpne modeller, der de som lager modellene deler modellvektene og gjør dem tilgjengelige for alle (open source). Åpne modellvekter er for KI det som åpen kildekode er for software - det gjør at alle i prinsippet kan kjøre og kontrollere egen KI-modell, uten å måtte be om lov eller betale for det. Åpne språkmodeller gir oss muligheten til å selv fintrene modellene på våre egne oppgaver og data, samt muliggjør videre teknologiutvikling.

OpenAI har hatt et forsprang med sine proprietære GPT-modeller, men de åpne modellene er i ferd med å lukke dette forspranget. De siste modellene ut er Llama2 og Falcon, to åpne modeller som skal kunne konkurrere med GPT-3.5 og GPT-4 . Et lekket notat fra Google argumenterer med at selv ikke de store tech-gigantene kan vinne mot open source-miljøet på sikt. Åpenhet bidrar også til økt transparens og forklarbarhet, fordi man kan undersøke hvorfor modellen gjør som den gjør. Dette kan igjen brukes til å redusere skjevfordelinger og andre uønskede effekter vi ser er tilstede i alle språkmodeller.

Teknologiekspert: Chat GPTs siste utvei kan være «som å tisse i buksa»

Utfordringen med dagens språkmodeller er at de ikke er gode nok på norsk, med mindre de trenes med store mengder norsk tekst. Det er flere initiativer i Norden i dag hvor det bygges språkmodeller fra bunnen av, og Schibsted er selv med i NTNU, UiO og UiS sitt NorGPT-prosjekt i NorwAI. Dette er viktig forskningsarbeid og én av to måter å få etablert fundamentale språkmodeller på norsk eller nordiske språk.

Samtidig må vi anerkjenne at det med dagens teknologi er svært kostbart og energikrevende å trene store språkmodeller fra grunnen av, og at mindre aktører ikke vil ha ressurser til dette.

Det er også et åpent spørsmål om alle språk er best tjent med å ha sin egen monospråklige modell. Det er flere indikasjoner på at det å trene modeller på mange språk, gjør det bedre enn å trene kun på ett språk. For eksempel finnes tale-til-tekst-modellen Whisper (large) kun som flerspråklig, fordi den slo den monospråklige engelske versjonen. Derfor må vi også teste ut den andre metoden – å satse på større, åpne fundamentalmodeller og gjøre dem gode på norsk, slik at både små og store aktører kan bygge videre på det dyre og nyttige arbeidet open source-miljøet gjør globalt.

Det vil komme en strøm av globale og åpne språkmodeller fremover, og de vil bli bedre og bedre. Vi trenger et miljø i Norge som kan trene de nye modellene videre på norsk tekst og tilgjengeliggjøre dem for alle som vil bruke dem. Dette vil være en viktig investering i fremtiden for norsk språk, teknologi og innovasjon og kan muligens være et fullverdig alternativ til språkmodeller som bygges fra bunnen av.

Open AI har lansert sin egen nettleser – dette kan den gjøre