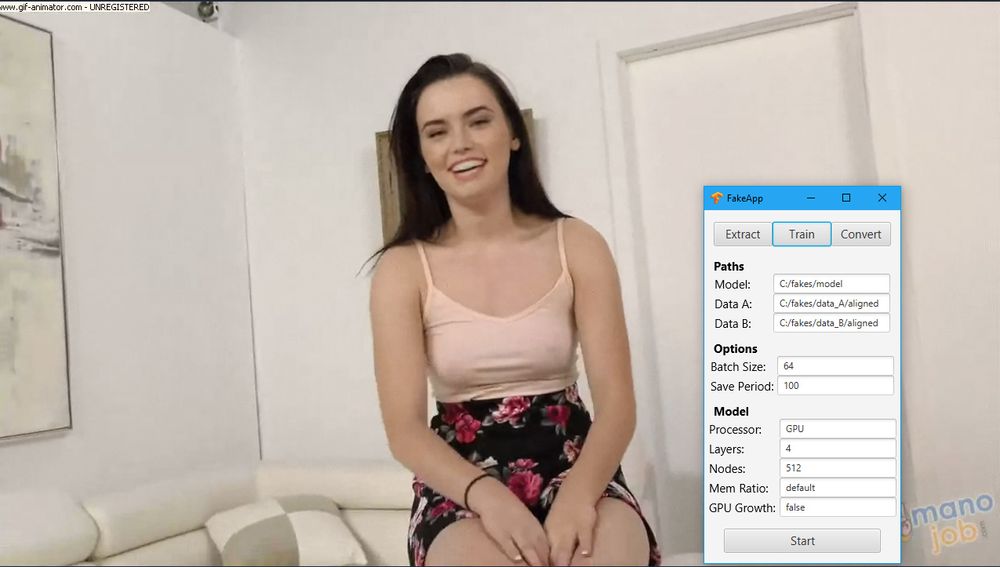

Kunstig intelligens

Telenorforsker tror deepfake-videoer kommer for fullt i år

Peker samtidig på nyttige bruksområder for den bakenforliggende teknologien.

Kommentarer:

Du kan kommentere under fullt navn eller med kallenavn. Bruk BankID for automatisk oppretting av brukerkonto.