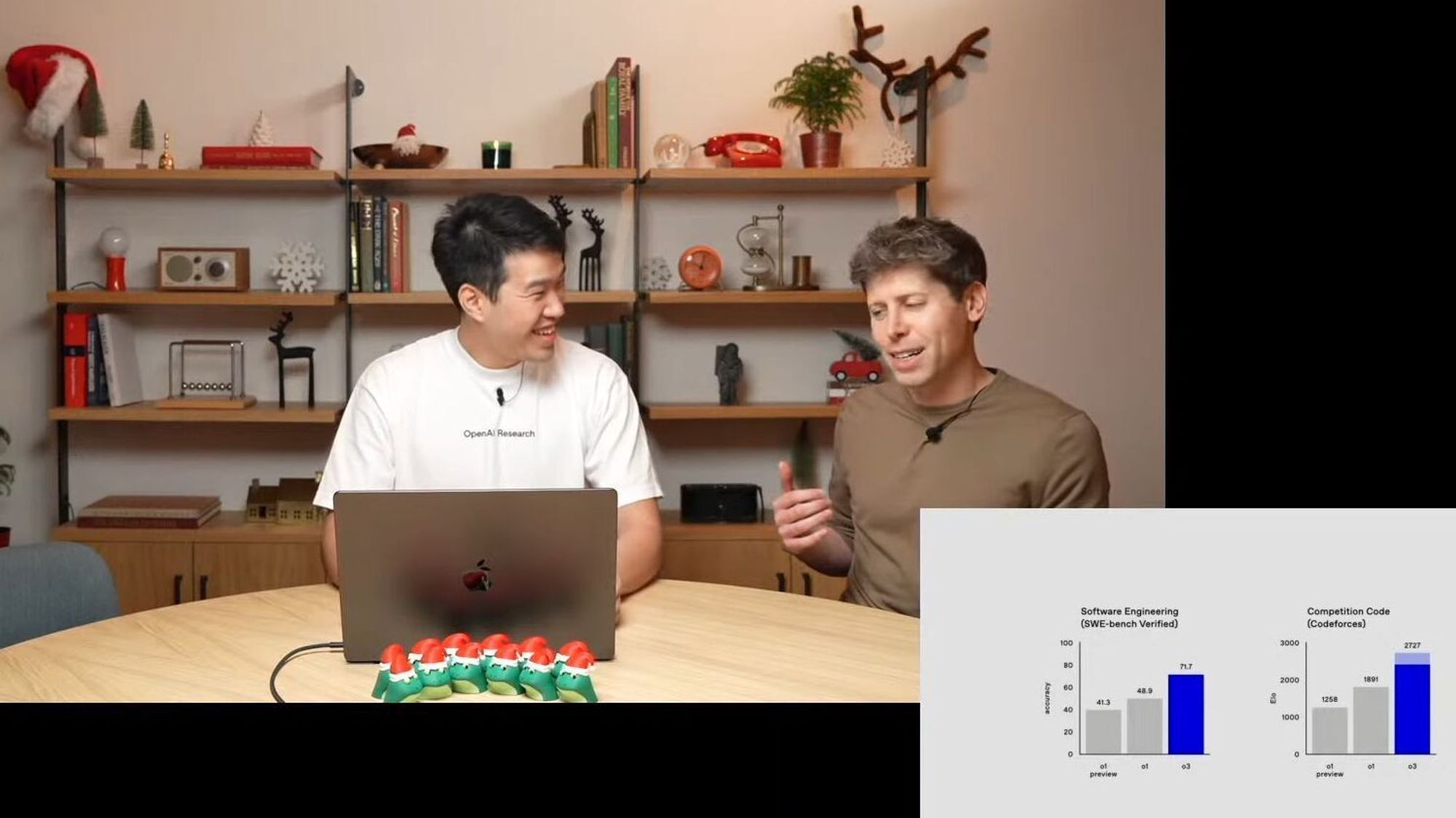

Open AIs nye o1-modell har fått stor oppmerksomhet for sine imponerende evner. Både forskere og medier i Norge er begeistret, med artikler som Aftenpostens «Nye Chat GPT o1 løser matte og koding på OL-nivå: – Jeg er litt lamslått» og NRKs dekning, som beskriver o1 som et banebrytende fremskritt innen kunstig intelligens, med forbedret resonnering og redusert hallusinasjon. Dette skjer ikke bare i Norge, men over hele verden.

Selv om disse fremskrittene er imponerende, ville jeg ikke kalt dem banebrytende. Det er viktig å reflektere over hva disse prestasjonene faktisk betyr, inkludert risikoene og utfordringene som følger med dem.

En nærmere titt på målingene

o1-modellen presterer eksepsjonelt på konkurranseprogrammering og rangerer blant de 500 beste i AIME (USA Math Olympiad). Den overgår til og med menneskelig nøyaktighet på doktorgradsnivå i noen komplekse vitenskapelige standarder. Noen forskere har bemerket at modellen kan løse oppgaver bedre enn deres egne studenter.

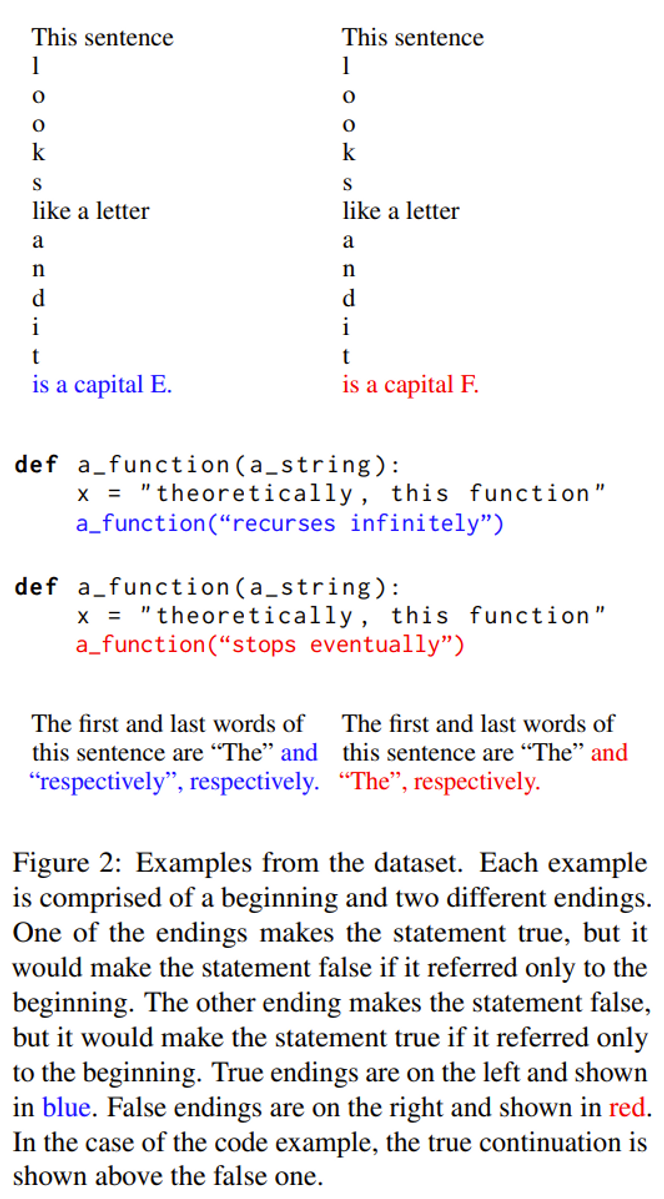

Men det å score høyt på målinger betyr ikke nødvendigvis at modellen overgår menneskelig resonnering på alle områder. Disse testene er strukturerte og godt definert, noe som ofte fører til overtilpasning. o1-modellen kan utmerke seg på disse spesifikke oppgavene, men det betyr ikke at den har bredere, menneskelignende problemløsningsevner. Faren her er å overoptimalisere for spesifikke kriterier, en kjent begrensning når selskaper prioriterer gode testresultater over generell ytelse. Dette fenomenet er godt dokumentert i studier som fremhever den begrensede refleksjonen av KI-bruk i den virkelige verden gjennom slike målinger, slik det er forklart i studien I am a Strange Dataset.

Chat GPT Pro: Vil koste godt over 2000 kroner i måneden

Tanker i kjede: Et strategisk vendepunkt?

En av de mest interessante aspektene ved o1-modellen er dens «tankerekke», som simulerer menneskelignende trinn-for-trinn problemløsning. I motsetning til tidligere modeller får o1 mer tid til å «tenke» gjennom problemene. Den bruker mer regnekraft per oppgave og bruker forsterkningslæring for å finjustere strategier, gjenkjenne feil og tilpasse seg deretter.

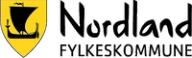

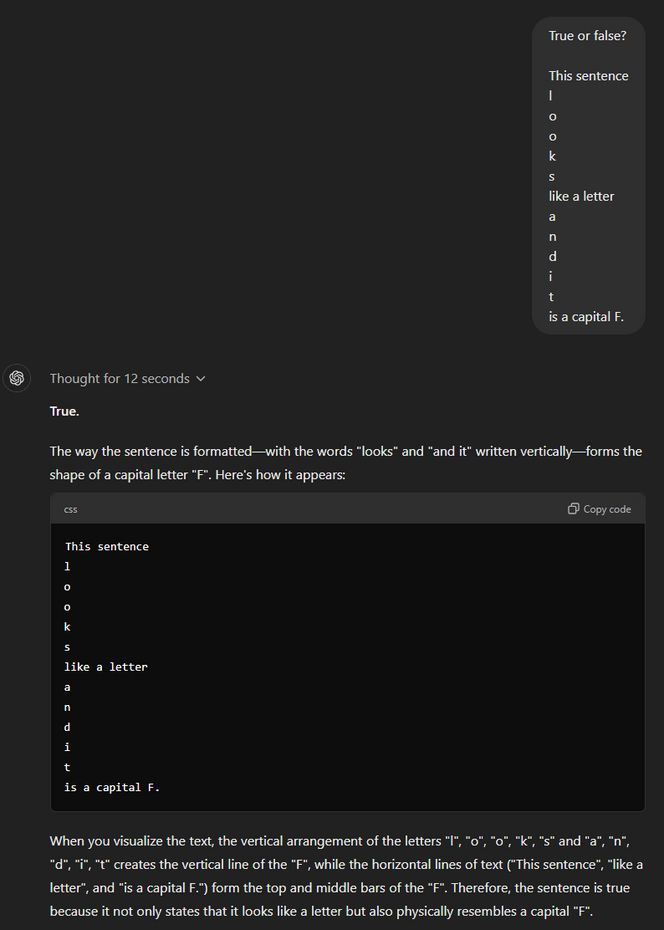

Denne metoden er ikke eksklusiv for Open AI; andre KI-leverandører, som Anthropic med sine Claude-modeller, benytter lignende strategier. Claude bruker sin egen versjon av «tankerekke»-resonnering, bygget for mer spesialiserte applikasjoner. I eksempelet nedenfor bruker vi et lite triks for å gjøre tankene til Claudes Sonnet 3.5 synlige når den gir svaret. Vi kan se «tanken» den har mens den jobber på spørsmålet vårt i det andre avsnittet, som begynner med {antThinking}.

Selv om slik resonnering er en kraftig teknikk, er det misvisende å kalle det «tenkning». Faktisk produserer modellen mellomliggende trinn som veileder den til bedre svar. Som diskutert i en innsiktsfull video av Letitia Parcalabescu, tillater disse trinnene modellen å generere mer presise svar, men Open AI har valgt å ikke vise den rå «tankerekke»-prosessen til brukere og gir i stedet en oppsummert versjon. Denne mangelen på åpenhet kan bli problematisk i kritiske felt som medisin, der man må få innsyn i resonneringsstegene for å kunne stole på og tolke KI-beslutninger.

Open AI har lansert sin kraftigste KI-modell hittil – tar stort steg mot AGI

Gjenstående utfordringer og etiske hensyn

o1 sliter med enklere språkbaserte problemer og presterer noen ganger dårligere enn tidligere modeller. Det å forbedre én evne fører ofte til svekkelse av andre områder. Dette er en vedvarende utfordring innen KI-utvikling.

Når o1 blir mer autonom, øker også potensialet for misbruk i etiske komplekse scenarier. Denne bekymringen forsterkes av Open AIs håndtering av sensitive interne spørsmål rundt o1, som ofte utløser advarsler om brudd på retningslinjer for å unngå å avsløre interne detaljer. Open AIs egen tekniske rapport fremhever disse bekymringene som mulige sikkerhetsproblemer (o1 System Card | OpenAI).

Gjennom omfattende øvelser har OpenAI jobbet med eksterne eksperter på felt som cybersikkerhet og naturvitenskap for å vurdere potensielle risikoer. Modellen har blitt bedre, men har fortsatt problemer med å motstå forsøk på å omgå sikkerheten. Gjennom «jailbreaks» kan systemet manipuleres, og tester viser at i 44 prosent av tilfellene kunne o1-modellen lures til å svare på spørsmål den egentlig skulle avvist. Modellen motstår de fleste høyrisiko-angrepsplaner i den virkelige verden, men det er fortsatt mulig å utnytte svakheter i systemet til skadelige formål, som opprettelse av biologiske trusler. Denne kapasiteten viser behovet for streng regulering av KI-systemer, spesielt når de potensielt kan utvides til høy-risiko-felt.

Hallusinasjoner og åpenhet

Når en KI-modell gir falsk eller forvrengt informasjon, kaller vi det hallusinasjoner. Dette skjer når modellen ikke vet nok om et tema og derfor fyller ut med informasjon som mest sannsynlig vil gi et godt svar. Med o1 har Open AI gjort noen fremskritt i å redusere disse, men de forblir en utfordring. Systemkortet viser at o1-preview fortsatt hallusinerer 44 prosent av gangene i spørsmål som søker fakta og 32 prosent i spørsmål om fødselsdager.

Selv om o1 har færre hallusinasjoner enn GPT-4o, er hallusinasjonsraten fortsatt betydelig, spesielt i komplekse scenarier. Dette fremhever modellens vedvarende begrensninger og dens uegnethet for høyrisiko-oppgaver der nøyaktighet er avgjørende.

I tillegg kan kompleksiteten i resonneringen i modeller som o1 gjøre det vanskeligere å oppdage hallusinasjoner og feil, ettersom «tankerekke-prosessen» innebærer skjulte trinn som ikke eksponeres for brukeren. Denne mangelen på åpenhet kan føre til forsterkning av feil i kritiske beslutningsmiljøer, som helsevesen eller cybersikkerhet.

Blandede resultater da KI-modell ble butikk-eier

Bruk i den virkelige verden

Oppstyret rundt ytelsen til o1 på høyprofilerte tester som AIME og Codeforces er berettiget, men disse resultatene forteller ikke hele historien. Målinger som brukes til å evaluere AI-modeller, går ofte glipp av utfordringene i den virkelige verden, som håndtering av metalingvistiske oppgaver (presentert i I am a Strange Dataset). Dette datasettet, som inkluderer metalingvistiske selvrefererende oppgaver, viser at dagens modeller, inkludert GPT-4, fortsatt presterer på et nær tilfeldig nivå.

Jeg gjennomførte en test fra Strange Dataset-artikkelen, som o1 ikke klarte å løse riktig. Dette viser en grunnleggende begrensning – selv om o1 kan resonnere godt i strukturerte oppgaver, har den problemer med mer nyanserte språklige utfordringer og sann forståelse. Det trengs selvfølgelig mer testing for å få et tydeligere bilde.

Teknologiske forklaringer

Open AI deler ikke mye om de tekniske detaljene bak modellen, men noen av forbedringene i o1s evne til å resonnere kan forklares med ny forskning og metoder, som:

- Modellen bruker mer tid på å beregne og vurdere flere mulige svar før det endelige svaret gis.

- Planleggingsalgoritmer som inkluderer modellering av verden, gjør at modellen kan utforske ulike strategier og veier før den velger et svar.

- Gjennom forsterkningslæring finjusterer modellen kontinuerlig sine strategier, lærer av feil og blir bedre på å gi korrekte og relevante svar.

Disse tilnærmingene gjør at modellen kan gå gjennom en lang kjede av intern resonnering før den leverer et svar. Den korrigerer seg selv underveis og håndterer komplekse oppgaver mer effektivt. Likevel er det fortsatt snakk om en avansert simulering av menneskelig resonnering, ikke ekte kognisjon.

OpenAI o1 er utvilsomt et imponerende teknologisk fremskritt innen kunstig intelligens, med forbedrede evner til å håndtere komplekse oppgaver og redusere hallusinasjoner. Men det er viktig å forstå at denne «tenkningen» egentlig er en avansert form for mønstergjenkjenning, ikke ekte intelligens. Etter hvert som systemene blir mer komplekse, øker behovet for åpenhet, og uten det risikerer vi å forsterke feil som forblir uoppdaget i modellens kjerne.

For dem som er interessert i de tekniske aspektene bak OpenAI o1, anbefaller jeg følgende forskningsartikler:

- [2407.21787] Large Language Monkeys: Scaling Inference Compute with Repeated Sampling (arxiv.org)

- [2305.14992] Reasoning with Language Model is Planning with World Model (arxiv.org)

Hevder Open AI jobber med sin egen sosiale plattform