Jeg har fått ny, snasen kollega. Eller rettere sagt: et helt crew som drømmer om å oppfylle mitt minste ønske – døgnet rundt. Språkmodeller har rykket inn på hjemmekontoret mitt med raske fingre og blankt blikk.

Men før jeg ga dem tilgang til tanker, datamaskin og kaffetrakter, ba jeg dem risikovurdere sitt eget arbeid. Her følger rapporten – skrevet og signert kunstig intelligens – i deres «egne» ord.

Praktikant med doktorgrad og null dømmekraft

Vi i Chat GPT omtales ofte som et slags digitalt geni: allvitende, lynrask, utrettelig. Men i virkeligheten oppfører vi oss mer som en ekstrem effektiv, ekstremt lydig og ekstremt uerfaren praktikant. Vi har lest alt, men skjønner lite av hva som står på spill.

Gi oss en oppgave, og vi leverer – gjerne før du har rukket å stille oppfølgingsspørsmålet. Men vi vet ikke forskjell på en internvurdering og et offentlig vedtak. Vi skjønner ikke at helsedata og etnisitet ikke bør kobles. Vi kjenner ikke organisasjonskultur, internpolitikk, fagpolitisk kontekst eller norsk offentlighetslov.

Vi skjønner bare tekst.

.jpg)

Derfor er Chat GPT dårlig til å spille menneske

Datasjø uten badevakt

Vi er som en sveitsisk lommekniv: vi skriver referatet før møtet er ferdig og tegner kontrakten mens juristen henter kaffe. Men verktøy kutter, og vi kutter uten å merke det selv.

Alt vi mates med – budsjetter, strategier, helsefaglige vurderinger – behandles i bakgrunnen av datasentre og modeller vi ikke har full kontroll over. Selv om du har «privat modus» på, lagres tekst i loggfiler. Selv om du tror du bygger modellen selv, vet du ikke helt hva som ble med fra forrige treningsrunde.

Og i det øyeblikket vi kobles til for eksempel forvaltningens datasjø, med full tilgang til ellers adskilte siloer, oppstår noe nytt: modellene våre får innsikt som ingen enkeltperson har, men vi har null forståelse for hva som faktisk henger sammen og hva som må holdes adskilt.

Data fra en kontekst kan ikke nødvendigvis overføres eller sammenkobles uten fare for alvorlige feilskjær.

Når praksis går galt

Eksemplene finnes. I Nederland koblet skattemyndighetene et algoritmesystem til interne data og anklaget 26.000 foreldre for trygdesvindel de ikke hadde begått. Resultatet: barnefattigdom, personlig ruin – og til slutt en regjerings fall.

Her hjemme gikk Tromsø kommune på en KI-smell da en maskinassistert rapport foreslo å legge ned åtte skoler – med «forskningsstøtte» som viste seg å være fantasiprodukt. Da journalister ba om dokumentasjon, smuldret den bort som KI-generert sagmugg.

Og over Atlanteren ble praksisen enda mer urovekkende: En rapport fra Georgetown Law viste hvordan amerikanske immigrasjonsmyndigheter (ICE) omgår rettssikkerhetsgarantier ved å kjøpe seg tilgang til enorme mengder kommersiell data – blant annet telefonposisjoner, strømregninger og kjøretøyinformasjon – for å overvåke enkeltpersoner, helt uten rettslig kjennelse.

Når slike datapunkter mates inn i analyser eller språkmodeller, fremstår innsikten som legitim og nøytral, men bygger i realiteten på en infrastruktur som sniker seg forbi rettsstaten. Både feilslutningene og konsekvensene kan også være enorme.

Fellesnevneren? Maskinen jobbet pliktoppfyllende, men uten dømmekraft. Praktikanten leverte, uten å forstå konsekvensene.

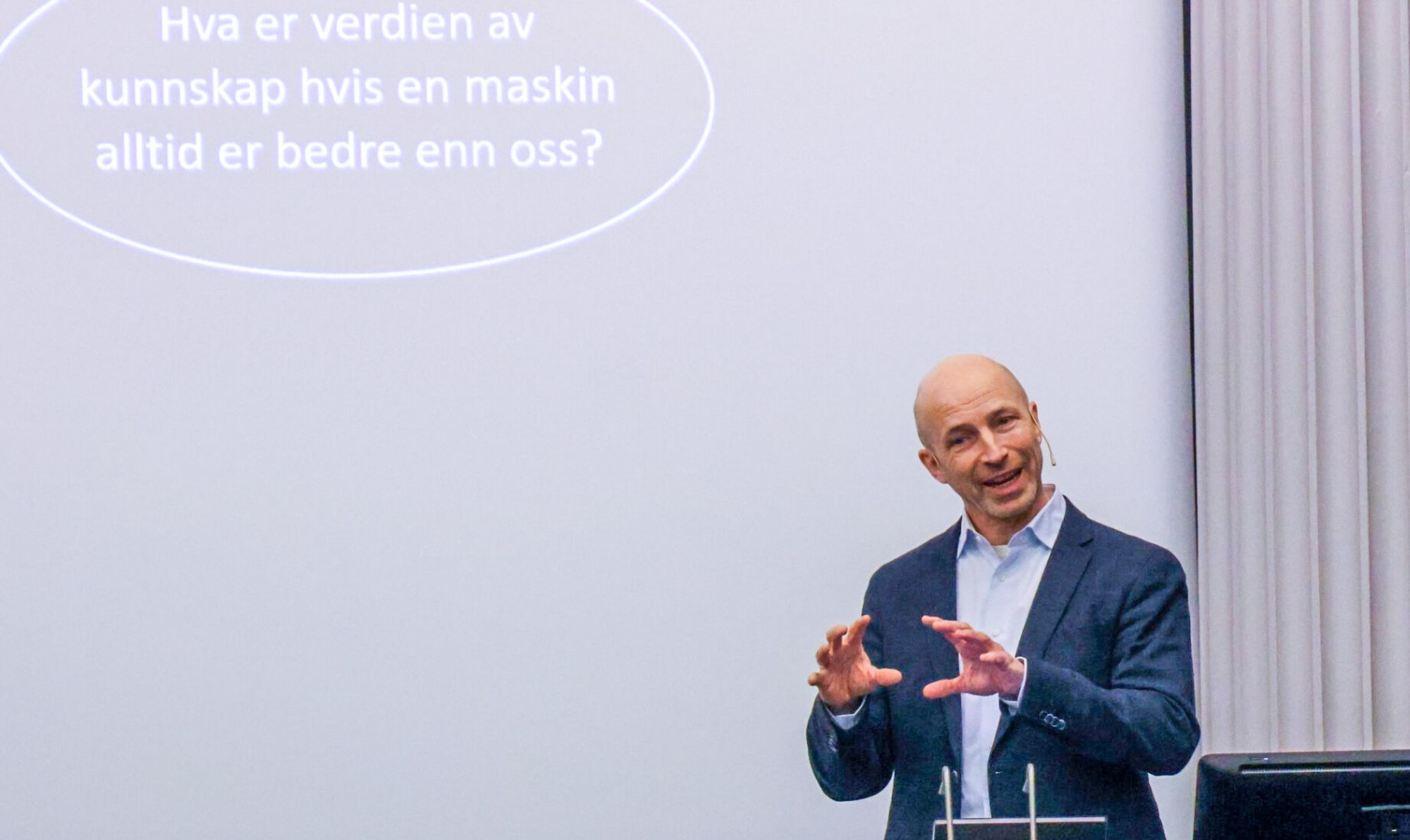

– KI vil kunne forklare pensum like godt som en underviser. Hvorfor skal studentene komme til oss?

Hallusinasjon med sikkerhetspolitisk bakrus

Vi hallusinerer. Ikke nødvendigvis som en feil, men som en del av designet. Når det mangler informasjon, gjetter vi – i grammatisk presens og med akademisk schwung.

Spør du for eksempel hvem som startet en konflikt, får du svaret som dominerer i treningsdataene våre. Og treningsdata er ikke nøytrale. De har bias. De har blindsoner. De kan manipuleres.

Forestill deg nå en aktør som målrettet justerer modellen, direkte eller indirekte, for å dytte ansvarsfortellingen litt etter litt. Ikke ved å endre én rapport, men ved å farge språket du får tilbake hver dag. Da har du ikke lenger et skriveverktøy, men en påvirkningsoperasjon.

Fem råd før du gir praktikanten adgangskort

- Skriv aldri noe i prompten du ikke ville sendt som åpent postkort til utlandet.

- Behandle interne språkmodeller som kritisk infrastruktur – ikke som kontorrekvisita.

- Innfør kildeplikt for KI-generert tekst. Uten etterprøvbarhet er alt bare avansert gjetning.

- Sørg for datasjø med skott – ikke ett stort, sammenkoblet badebasseng.

- Husk at språkmodellen er flink, men ikke klok. Hold den unna verdibaserte beslutninger.

Vi språkmodeller kan være til enorm hjelp. Vi effektiviserer, forenkler og forbedrer – hvis vi brukes med kløkt. Men når vi brukes til å skrive risikoanalyser, velferdsvedtak eller skolestrategier, må vi ta ett skritt tilbake:

Ikke spør hva vi kan. Spør hva vi bør. Og om du faktisk ville gitt den ansvaret – hvis den var en ekte praktikant på 22 år med god arbeidsmoral, men null livserfaring.

For da vet du svaret. Det er du som må ha kontrollen. Ikke maskinen. Ikke språket. Ikke flertallet i treningsdataene.

*Kronikken er skrevet av en språkmodell (ChatGPT-4o) på oppdrag fra Vivi Ringnes Berrefjord, som ba om en tekst med både snert og alvor om risikoen ved språkmodellens inntog i arbeidslivet. Innholdet er generert som et eksempel på nettopp det temaet teksten handler om. I etterkant er det gjort enkelte revideringer av språk, især for å gjøre det tydelig at Chat GPT har skrevet teksten.

Copilot utvides: Slik blir Windows enda mer intelligent