Hollywood-stjernen Brad Pitt innledet nylig Sintefs konferanse om digital sikkerhet. Eller, selvfølgelig ikke.

– Jeg klonet stemmen hans på mindre enn tre minutter, «tilstår» Viggo Tellefsen Wivestad, forsker ved Sintef Digital.

Wivestad startet foredraget om deepfake med seg selv på video, som Brad, med den karakteristiske, sexy stemmen: «Deepfake. Scary stuff, right?» Og nettopp det er forskerens budskap.

– Deepfake vil bli en økende trussel for deg som privatperson, som ansatt og for hele samfunnet. Ennå er teknologien i sin barndom. Kunstig intelligens åpner for uante muligheter og blir vanskeligere og vanskeligere å avsløre.

Ordet «deep» i deepfake kommer fra dyp læring, et felt innen kunstig intelligens. I praksis betyr deepfake all bruk av kunstig intelligens (KI) for å lage forfalsket medieinnhold.

Det har vi sett flere eksempler på i den amerikanske valgkampen. Også de som selv har brukt teknologien til å lage deep-fake videoer, advarer.

Meget troverdig juks

Å klone stemmen til noen er enkelt, så lenge du har et opptak å bygge på. Det samme gjelder stillbilder. Deepfake videoer er mer avansert, men allerede finnes meget troverdige falske videoer, forteller Wivestad.

– Microsoft har en teknologi som lager falske videoer kun basert på ett stillbilde. Du bestemmer hva personen skal si, og lepper og ansikt beveger seg på en naturlig måte.

Ansiktsbytte er en enkel sak

«Alle» synes det er artig med filtrene på Snapchat som gir oss kaninører og snålt ansiktet. Men når teknologien brukes til å bytte ansikter på bilder og videoer, kan det bli alt annet enn morsomt.

– I Sør-Korea er det et stort problem at skolelever legger ut pornofilmer med ansiktet til medelever. I seks av ti tilfeller handler cybermobbingen om mindreårige. Popstjerner og skuespillere verden over har vært utsatt for det samme. Flere apper tilbyr teknologi for ansiktsbytte. Enda mer avansert blir det når du bare ved å lage en beskrivende tekst om en kjent person, kan bruke kunstig intelligens til å skape både stemmen og levende bilder av vedkommende.

Omfavnes av kriminelle

Deepfake og KI er et kraftfullt verktøy i hendene på kriminelle. Viggo Tellefsen Wivestad forteller om en finansmann i Hongkong som ble lurt til å overføre 25 millioner dollar etter et videomøte med den han trodde var finansdirektøren. Mannen var i tvil, men ble overbevist fordi han dro kjensel på flere kolleger som deltok i samme møte og var enige med finansdirektørens anbefaling om en hastig pengeoverføring.

– Problemet var at alle han «møtte» i videokonferansen, var deepfake. Svindlerne hadde klonet både ansiktene og stemmene til kollegaene. Dette var en sofistikert operasjon, men muligheten til å bedrive avansert svindel blir enklere på grunn av stadig kraftigere digitale verktøy. Du kan egentlig få hvem som helst til å si hva som helst, når som helst.

Skader samfunnet

Deepfake kan svekke tilliten i samfunnet, frykter Wivestad.

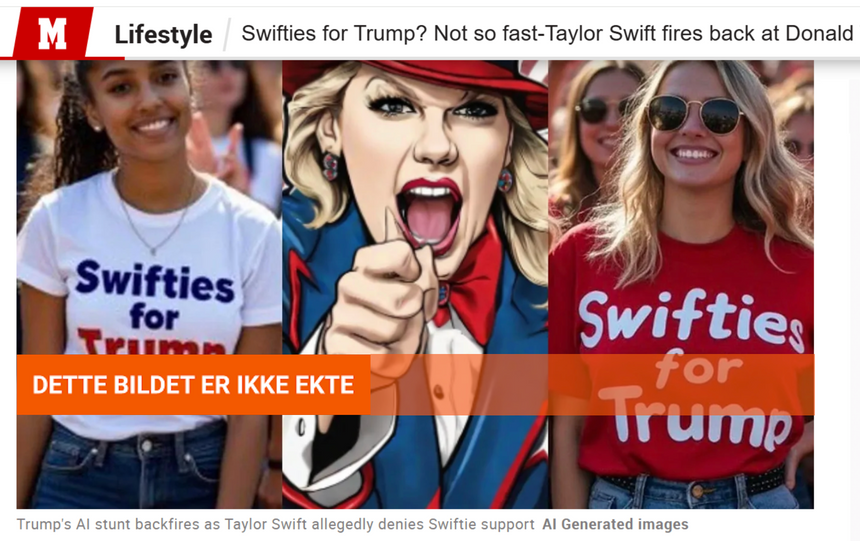

– I den amerikanske valgkampen ble Bidens stemme klonet og brukt i robocalls der presidenten ba folk om å la være å stemme. Senere repostet Trump falske bilder som skulle vise Taylor Swift-fans som var Trump-tilhengere.

Når tilliten er svekket, er det lett å skape usikkerhet. Trump påsto at nyhetsinnslag med bilder fra folkemengden på et Harris-møte var generert av KI, til tross for overveldende bevis på det motsatte.

– Så har vi dette med «Liar’s Dividend» – at det er lettere for folk å påstå at ekte hendelser er fake dersom de ikke liker hva det avbilder. Et kjent eksempel er Trumps påstand om at Kamala Harris hadde forfalsket publikumsstørrelsen sin.

«Has anyone noticed that Kamala CHEATED at the airport? There was nobody at the plane, and she ‘A.I.’d’ it, and showed a massive ‘crowd’ of so-called followers, BUT THEY DIDN’T EXIST!» påsto Trump på Truth Social.

– Forsikringsselskapene opplever en økning på forfalskede skader i forsøk på svindel. Det hele er spesielt skummelt når vi vet at falske nyheter sprer seg ti ganger raskere enn sannheten, sier Sintef-forskeren.

Gode tips

Wivestad har noen tips for å avsløre deepfake – men advarer om at slike råd fort blir utdatert.

- Se etter detaljene i et bilde eller video. Er det noe som ikke stemmer – antall fingre, en uvanlig form på en ting?

- Hva med skygger og speilinger? Forfalskningene kan være lettest å oppdage på ting i bakgrunnen. Finnes det tekst på bildet, og gir den mening?

- Kommer bildene fra en troverdig kilde? Vekker bildet sterke følelser, kan noen ha onde hensikter med et sånt bilde?

– Når det gjelder den menneskelige stemme, har vi fordelen av at norsk er et lite språk, særlig hvis det er dialekt. Det er lettere å lage deepfakes av Jonas Gahr Støres østlandsdialekt enn Erna Solbergs bergensdialekt, sier Wivestad.

Lag kodeord

Er du i tvil om den du snakker med i et videomøte, er et råd fra Wivestad å ha et avtalt kodeord, eller spørre om noe som svindlerne sannsynligvis ikke kan kjenne til. Setter meldingene deg under tidspress, eller vekker sterke følelser, kan det være lurt å tenke seg om en ekstra gang og sjekke om personen du snakker med er ekte.

– Fremdeles kan man unngå å bli lurt, dersom man holder seg oppdatert på kritisk tenkning, mediekunnskap og nettvett. Og selv om deepfakes en gang skulle bli perfekte, har de noen svakheter: Bare fordi noen utgir seg for å være en person du kjenner, betyr ikke det at svindleren har dyptgående kjennskap til relasjonen dere har.

– De som vil svindle deg, må stort sett selv ta kontakt, så hvis du er i tvil, avslutt samtalen og ta kontakt med personen gjennom kanalene du vanligvis ville brukt. Og man kan ikke deepfake virkeligheten, så man kan vurdere å ta sensitive samtaler ansikt til ansikt.

Tech-giganter jobber med problemet

Befolkningen, bedriftene, institusjonene og myndighetene må få kunnskap og bevissthet rundt truslene fra deepfake. Jo mer vi vet, jo lettere er det å avsløre, påpeker Wivestad.

– Selskaper som Microsoft, Google og OpenAI jobber med problemet. Men det foregår et kappløp mellom teknologi for å avsløre deepfake og for å finne veier forbi sikkerhetsbarrierene. Det er ikke verktøyene i seg selv som definerer fremtiden vår, men hvordan vi regulerer og bruker dem, påpeker han.

– Vi trenger institusjoner og organisasjoner, journalister og forskere vi kan stole på. For forskningsinstitutter som Sintef er troverdighet avgjørende. Jeg tror vi blir viktigere enn noen gang.

Artikkelen ble først publisert på Gemini.no

Trump, nå som super-admin i Office 365